Um sistema que usa algoritmos e softwares para mapear padrões nos rostos das pessoas e assim identificar ou confirmar a sua identidade. Essa é a base do reconhecimento facial, um tipo de tecnologia que já pode ser observado e aplicado no nosso dia a dia, como, por exemplo, para desbloquear telefones, aplicação da lei, controlar aeroportos e fronteiras, encontrar pessoas desaparecidas, reduzir crimes em estabelecimentos comerciais, operações bancárias, entre outros.

“O reconhecimento facial é uma das principais aplicações da Inteligência Artificial, sobretudo do Aprendizado de Máquina, e é amplamente difundido no mundo e utilizado principalmente na segurança de sistemas de comunicação e vigilância”, explica o professor auxiliar Jonathan da Silva Bandeira, do curso de Análise e Desenvolvimento de Sistemas (ADS) do Centro Universitário Tiradentes (Unit Pernambuco).

Mas descobertas recentes apontaram um problema de ordem social, que levanta um intenso debate sobre discriminação. Partindo da premissa que os sistemas de reconhecimento detectam um rosto em formas geométricas e algorítmicas, para em seguida montá-lo como um quebra cabeça, esse processo acontece de forma diferente para pessoas brancas e negras. “A Netflix tem um documentário muito interessante chamado Coded Bias, que traz um relato técnico e ao mesmo tempo uma denúncia social da pesquisadora do Instituto de Tecnologia de Massachusetts (MIT), Joy Buolamwini, acerca do viés presente em algoritmos de reconhecimento facial”, detalha Bandeira.

A cientista da computação descobriu que sistemas de reconhecimento facial não são precisos ao identificar pessoas negras, principalmente as mulheres. Coded Bias pretende expor um lado da tecnologia que pode acabar reproduzindo discursos preconceituosos e opressores. O site CinePop, fez uma crítica positiva ao documentário e diz que “nos levando a uma jornada reveladora…nos mostrando camadas ainda mais profundas de uma tecnologia que impacta diretamente na vida rotineira da população mundial”.

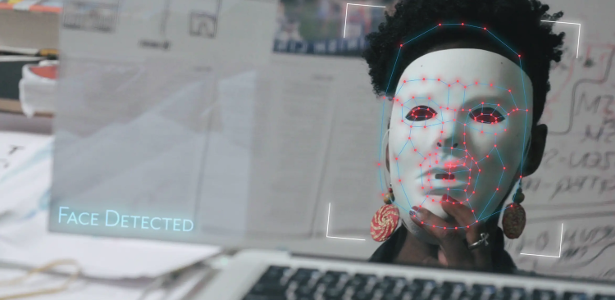

Para o professor, Coded Bias é notável pela reflexão que traz acerca do tema e por explorar uma falha grave até então relevada pela comunidade científica dessa área. “No documentário, vimos que os sistemas, que a princípio foram construídos para reconhecimento facial, não são capazes de reconhecer o rosto de uma pessoa negra como um rosto se este for exposto ao natural. Ao se utilizar uma máscara branca, no entanto, os modelos exemplificados são capazes de realizar o reconhecimento. Isso é extremamente delicado”, alerta ele, que levanta um forte questionamento: será que as máquinas estariam programadas para serem racistas?.

Preconceito tecnológico

O processo de aprendizagem de uma máquina acontece de acordo com os Modelos de Aprendizado que lhes são apresentados. No documentário, a base de dados utilizada envolve, em sua maioria, informações referentes a rostos maioritariamente masculinos e de predominância étnica branca, o que traz pouca diversidade. Para o professor, o problema não está na programação dos algoritmos em si, mas na sua alimentação e nos dados com os quais aprendem.

“O grande problema está em quem preparou e difundiu as bases de dados utilizadas até então. O outro problema está na manutenção desses modelos por tanto tempo. Os dados a partir dos quais uma máquina aprende são como os valores que ela reproduz. Num paralelo ao nosso cotidiano, é como se passássemos aos nossos filhos ideais racistas e preconceituosas. Eles absorveriam esses valores quando crianças e os reproduziriam quando adultos. Os dados enviesados são o reflexo de uma sociedade parcial em seus valores”, destaca Jonathan, acrescentando que nossas sociedades vivem cada vez mais tecnologicamente, mas as máquinas podem produzir inúmeros problemas sociais existentes.

Transformações

O documentário da Netflix também traz questionamentos sobre o uso dessas ferramentas por empresas privadas ou por governos “democráticos”, e sua repercussão levou vários governos nacionais e regionais a suspenderem ou reverem seus sistemas de reconhecimento facial. O professor acredita que, para os negros, o debate e seus frutos representam uma conquista dupla, nos pontos de vista social e científico.

“Como técnico e cientista, posso dizer que essa denúncia é uma vitória para a comunidade científica e espero que com isso, não apenas as fontes de aprendizado sejam reformuladas, mas também haja uma reforma íntima na sociedade. Somos professores, temos o dever moral de repassar esse conhecimento para nossos alunos, fazendo com que eles sempre procurem pensar em soluções inclusivas e igualitárias” afirma Jonathan, ressaltando a importância da construção e da defesa da criação e construção de máquinas e sistemas inteligentes que sejam imparciais, baseados em critérios justos e de igualdade entre as pessoas.

Asscom | Grupo Tiradentes